Internet è, ormai, uno strumento centrale nella formazione dell’opinione pubblica, ed è inevitabile che vi si annidino numerosi elementi per i quali si rende necessario un accurato approfondimento; sia riguardo ai contenuti che alla particolare modalità di comunicazione.

Il flusso incontrollabile di informazioni è seriamente in grado di porre a rischio i fondamentali valori democratici: proprio la massima libertà espressa attraverso internet, che in assoluto costituisce un valore positivo, può portare con sé espressioni pregiudizievoli e visioni parziali dei fenomeni tali da rendere difficile cristallizzare il concetto stesso di “verità; anche se per le espressioni del pensiero questo aspetto non dovrebbe essere considerato un obbligo.

Su internet, però, vengono a determinarsi diverse dinamiche che portano ad intrecciarsi la libera manifestazione del pensiero e l’informazione.

Quali sono i rischi per le democrazie e per i diritti?

Cosa si intende per discorsi d’odio

I discorsi d’odio (hate speech) sono manifestazioni del pensiero che diffondono, incitano, promuovono e giustificano l’odio attraverso condotte che sono in grado di alimentare un clima generale molto pesante: l’affronto è diretto da una parte alla dignità di membri vulnerabili della società, dall’altra può configurarsi come un attacco all’inclusività.

Il discorso d’odio è rivolto spesso contro minoranze tendenzialmente marginalizzate, in genere contro soggetti deboli, con il preciso intento di marginalizzarli ulteriormente; mirando a negare i più basilari diritti di partecipazione.

Sono vari gli elementi che compongono “l’odio”, come: gli atteggiamenti basati su pregiudizi o l’accettazione di stereotipi, gli insulti, l’esclusione sociale, la ridicolizzazione e la discriminazione.

Nel nostro ordinamento manca una definizione precisa di cosa debba intendersi per “discorso d’odio”: da una parte perché la riflessione teorica sul tema in Italia appare ancora limitata; dall’altra perché spesso si fa riferimento a questo concetto semplicemente dandolo per scontato, non specificandone il significato e lasciandola definizione assolutamente generica e ambigua.

Da questa mancata definizione discende, quindi, una mancata regolamentazione specifica: è, quindi, necessario fare riferimento a normative esistenti (decreto legislativo 215/2003 e legge Mancino del 1993) che non definiscono il concetto ma lo ricomprendono indirettamente.

La libertà di espressione del pensiero in internet e nei social network

Le complesse considerazioni generali sulla libertà di manifestazione del pensiero sono ancora più spinose se calate nel vasto mondo virtuale di internet e dei social network.

Le particolari e peculiari dinamiche e modalità comunicative che si sviluppano sulla rete rischiano di alimentare cortocircuiti nei quali diviene impossibile decifrare uno standard di tutela applicabile. Per questo motivo la discussione su queste tematiche è sempre aperta e le soluzioni finora adottate hanno necessità di essere costantemente migliorate e ricalibrate.

L’attribuzione di un ruolo di controllo vasto e generico in capo ai service providers, alle piattaforme di condivisione e alle multinazionali attraverso la rimozione dei contenuti considerati offensivi rischia di sacrificare in maniera eccessiva e poco attenta la libertà di espressione del pensiero; può colpire manifestazioni totalmente inoffensive solo perché queste possono rientrare nei parametri di vigilanza e controllo stabiliti dalle piattaforme.

E quindi: quali sono attualmente i parametri utilizzati per il bilanciamento di interessi utilizzati dai service providers per eliminare queste manifestazioni d’odio online?

Si corre il rischio di compiere delle censure arbitrarie in quanto mancano misure intermedie applicabili.

C’è, però, un ulteriore elemento da tenere in considerazione: l’algoritmo e il suo funzionamento. Questo meccanismo, infatti, può alimentare pericoli di diversa natura che possono non solo mettere in crisi ma addirittura minare i caratteri fondamentali delle società democratiche.

La denuncia di Frances Haugen e i “Facebook Papers”

Nel mese di ottobre 2021 in America una ex dipendente di Facebook, Frances Haugen, ingegnera informatica addetta ai dati, ha denunciato la piattaforma per aver allentato la censura sui messaggi d’odio e sui contenuti che disinformavano sui risultati delle elezioni americane del 2020; finendo così per favorire la diffusione di messaggi su presunti brogli.

Secondo la dipendente, quindi, Facebook, dopo le elezioni americane del 2020 vinte da Joe Biden, non avrebbe censurato (come stabilito nelle sue linee guida) i messaggi d’odio presenti nei social; con l’intento di mantenere e fomentare questo tipo di discorsi e alimentando un clima molto pesante nel paese.

Facebook, infatti, considera come espressioni punibili gli attacchi, reali o percepiti, indirizzati a persona o ad un gruppo in base alla razza, etnia, nazionalità, religione, sesso o identità sessuale, orientamento sessuale, disabilità e malattia. È prevista, in questi casi, la rimozione del contenuto offensivo entro 24 ore.

Frances Haugen afferma, quindi, che quelle effettuate dopo le elezioni americane del 2020 sono state delle vere e proprie scelte accurate da parte della piattaforma; attraverso lo sviluppo e la distribuzione di algoritmi che hanno amplificato l’hate speech, cioè l’odio e la contrapposizione fra gli utenti.

I documenti interni diffusi dalla Haugen, i “Facebook Papers”, dimostrano come i meccanismi dei social network siano funzionali alla diffusione di disinformazione e discorsi di incitamento all’odio; molti dipendenti e dirigenti ne sono consapevoli.

Facebook non dispone dei mezzi tecnici per frenare questi gravi fenomeni o attua scelte consapevoli dettate dai profitti generati dalla piattaforma?

Questi meccanismi hanno contribuito all’organizzazione per l’assalto a Capitol Hill del 6 gennaio 2020: e, per questo motivo, nel gennaio 2022, è stato spiccato un mandato di comparizione per Facebook e altre piattaforme (Twitter, Reddit, Youtube) nell’ambito delle indagini della Commissione del Congresso americano.

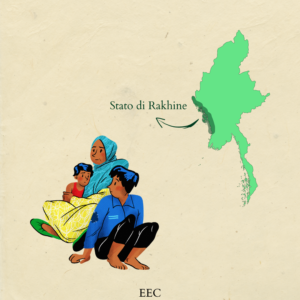

I crimini perpetrati contro i Rohingya nel 2017

I Rohingya sono una minoranza islamica presente nella regione settentrionale di Rakhine, in Birmania, al confine con il Bangladesh.

La legge sulla cittadinanza della Birmania non riconosce i Rohingya come etnia e, per questo motivo, non hanno diritto alla cittadinanza birmana e non possono viaggiare senza un permesso ufficiale.

La popolazione dei Rohingya è marginalizzata e perseguitata dalla dittatura birmana fin dal 1978; molti di loro sono costretti, infatti, a fuggire e rifugiarsi nel vicino Bangladesh.

Un feroce inasprimento delle violenze nei confronti della minoranza Rohingya riprende nel 2012; le piattaforme social, come Facebook, contribuiscono alla creazione di un clima acceso di tensione.

Gli utenti legati all’esercito e a gruppi ultranazionalisti buddisti, infatti, condividono oltre 1000 post, immagini, video, commenti dove attaccano pesantemente i Rohingya; e diffondono pericolose fake news (come quella per la quale i Rohingya erano pronti a un colpo di stato).

Per questo motivo Facebook decide, nel 2014, di avviare un’iniziativa per cercare di porre rimedio al disastro

Facebook predispone un pacchetto di sticker (“Panzagar” o “discorso dei fiori”) per rispondere ai contenuti d’odio; ma l’effetto che si viene a creare è esattamente l’opposto di quello desiderato.

L’algoritmo, infatti, interpreta gli sticker come un segnale di approvazione ai post che contengono i discorsi d’odio.

Nel 2017 si intensificano, ancora una volta, pesanti violenze ai danni della popolazione Rohingya; in questo caso, gli algoritmi di Facebook hanno contribuito, con i loro meccanismi e nel corso degli anni, alla perpetrazione di una vera e propria pulizia etnica. 700.000 Rohingya sono costretti alla fuga.

Tra il 2012 e il 2017 molti attivisti locali avevano avvertito Facebook di questi pericoli; ma l’azienda non ha recepito l’allarme e non ha applicato le adeguate politiche sul discorso d’odio.

Le comunità Rohingya e i loro leader, costretti a rifugiarsi nel vicino Bangladesh dove vivono in condizioni precarie, chiedono a Facebook, per cercare di porre rimedio alla situazione, di istituire un fondo da un milione di dollari per lo sviluppo di progetti educativi.

La risposta negativa dell’azienda non si fa attendere, in quanto: “Facebook non si impegna direttamente in attività filantropiche”.

Hate speech antipalestinese

Attraverso un’indagine condotta da una società di consulenza esterna, la Business for Social Responsibility, pubblicata nel mese di settembre 2022, è dimostrato che gli algoritmi di Facebook danneggiano i diritti dei cittadini palestinesi.

La destra israeliana, infatti, promuove discorsi d’odio sui social network contro il popolo palestinese e le piattaforme tollerano questo tipo di esternazioni. Le politiche delle piattaforme, infatti, sono applicate in modo arbitrario, attraverso:

la censura delle voci dei palestinesi e la successiva sospensione di account di molti giornalisti; l’eliminazione arbitraria di contenuti che documentano le violenze perpetrate dall’esercito e dalle forze dell’ordine israeliane (i funzionari israeliani esercitano forti pressioni sulle piattaforme per la rimozione di questo genere di contenuti).

La revisione condotta dalla Business for Social Responsibility, inoltre, afferma che le azioni di Meta, durante i bombardamenti israeliani nel maggio del 2021 sulla Striscia di Gaza, hanno avuto un impatto negativo sui diritti umani, sui:

“diritti degli utenti palestinesi alla libertà di espressione, riunione, partecipazione politica e non discriminazione”.

Per di più, il software di rilevamento dei contenuti d’odio è implementato per i post condivisi in lingua araba ma non per quelli in lingua ebraica; ancora una volta, quindi, i meccanismi dei social incidono sulla vita e sui diritti dei cittadini attraverso un’ingiustificata disparità di trattamento.

L’invasione russa dell’Ucraina e le modifiche di Meta alla policy sui discorsi d’odio

Meta decide, con l’invasione russa dell’Ucraina, di modificare “temporaneamente” la policy sui discorsi d’odio in questi due paesi e nei paesi confinanti.

L’azienda consente, quindi, la condivisione di messaggi d’odio purché il contesto sia chiaro, ovvero l’invasione russa dell’Ucraina.

È possibile la condivisione di messaggi come: “morte a Putin”, “morte ai soldati russi” o anche solo “morte ai russi”; deve trattarsi, in sostanza, di invocazioni generali e non di minacce specifiche.

Sono, inoltre, rimosse le limitazioni che impedivano di lodare il battaglione Azov, l’unità militare ucraina creata nel febbraio del 2014 dal militare e politico suprematista bianco Andrіj Bіlec’kyj, sempre nel contesto della difesa del paese.

Come mai, in un contesto di guerra, Meta sceglie consapevolmente di modificare la policy sui discorsi d’odio, con il serio rischio di alimentare il clima d’odio in questi paesi?

Queste scelte dimostrano tutta la loro pericolosità per le democrazie e, ancora di più, in contesti difficili come quelli di guerra: scelte concretamente tecniche ma teoricamente politiche che pongono le piattaforme in una scomoda e pericolosa posizione; e che devono portarci a riflettere e ad interrogarci sul loro ruolo nelle politiche nazionali e internazionali.

Elena Elisa Campanella